A nagy nyelvi modellek (LLM-ek) kétségtelenül a mesterséges intelligencia izgalmas területei, azonban ezeknek az algoritmusoknak számos kulcsfontosságú korlátja van, amelyeket érdemes megérteni és figyelembe venni.

Az LLM-ek egyik fő korlátja az elfogultságra való érzékenységük.

Amint azt megbeszéltük, az LLM-ek hatalmas mennyiségű szöveges adatra vannak kiképezve, ezek a bemeneti adatok jelentős mennyiségű torzítást tartalmazhatnak az adatokban. A bemeneti adatok torzítása a mesterséges intelligencia diszkriminatív szövegeit eredményezi, ami megerősítheti a meglévő társadalmi egyenlőtlenségeket.

Az LLM-ek másik korlátja az értelmezhetőség hiánya.

Az LLM-ek meglehetősen összetett algoritmusok, és általában a tanulást gyakran “black box-nak” nevezik, ami megnehezíti annak meghatározását, hogy a modell pontosan hogyan és miért jutott el egy adott kimenetre.

Ez megnehezítheti az LLM-ek teljesítményének megbízhatóságát, és kérdéseket vet fel a nagy téttel bíró döntéshozatali forgatókönyvekben való felhasználásukkal kapcsolatban.

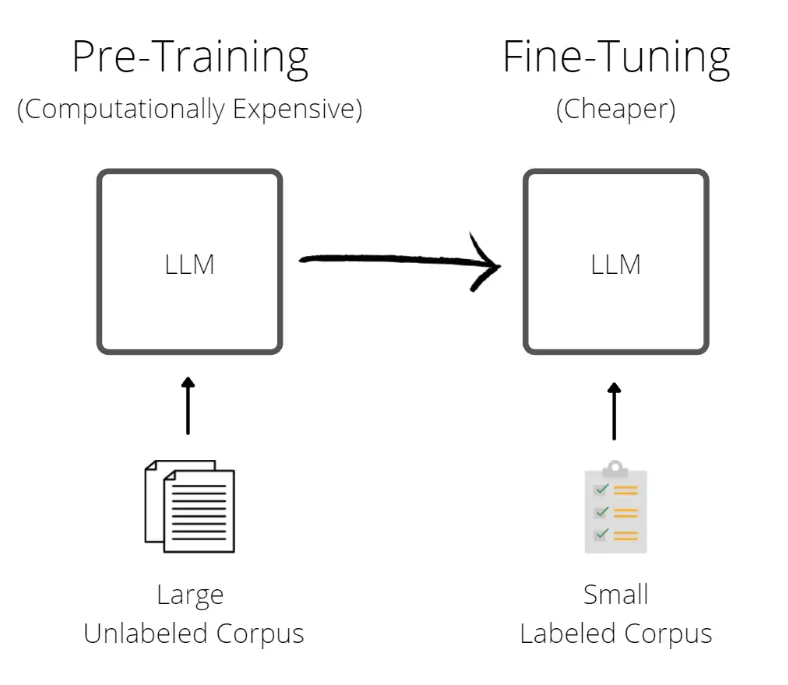

Végül az LLM-ek betanításához és futtatásához szükséges puszta méret és számítási teljesítmény jelentős korlátot jelenthet. Az LLM-ek és tágabb értelemben a tanulás hatalmas mennyiségű adatot és számítási erőforrást igényel, ami meglehetősen költségessé teszi fejlesztésüket és karbantartásukat, nem beszélve arról, hogy potenciálisan károsak a környezetre.

Összességében, bár az LLM-ek lenyűgöző fejlesztést jelentenek az AI-ban, jelenleg fontos korlátaik is vannak, amelyeket figyelembe kell venni. Mivel az LLM-k továbbra is egyre fontosabb szerepet töltenek be mindennapi életünkben, a kutatóknak és fejlesztőknek foglalkozniuk kell ezekkel a korlátokkal, hogy teljes potenciáljukat kiaknázhassák.